خیلی وقت پیش، در مورد این که جماعتی که خود را به نام نرمافزار آزاد معرفی میکنند، چگونه با پروژه جبیر و من برخورد کردند (لینک) و خب در سال گذشته هم گروه موسوم به «گروه کاربران گنو/لینوکس تهران» که به اختصار تهلاگ نامیده میشه هم برخورد جالبی نداشت (لینک) و خب این موضوعات، مجدد در یکی دو ماه گذشته داغ شدند. تصمیم گرفتم هرچه لازمه، بنویسم. البته بهتره قبل از اون، این مطلبی که در مورد تیر ۹۹ و اتفاقات پیرامونش هم نوشتم بخونید.

و این رو هم پیشاپیش، هشدار میدم که این مقاله، احتمالا شروعی بر اتفاقی به بزرگی و با حاشیههای تیر ۹۹ باشه، اما شخصا ترجیح خواهم داد که دور از گود بایستم. همانگونه که بسیاری از آقایان، دعواها را میسازند و بیرون گود میایستند و میگویند «لنگش کن».

نرمافزار آزاد، محلی است برای یادگیری، نه دعوا و ترولبازی

گرچه احتمالا پس از این که این مطلب انتشار یابد، بسیاری از دوستان تلاش میکنند افراد حاضر در جامعه را متقاعد کنند که این بلاگ، به قصد ترول نوشته شده است، باید بگویم که خیر.

زمانی، دقیقا همان زمان که انجمن اوبونتو – که شاید هنوز هم از معدود هابهای نرمافزار آزاد در وب فارسی باشد – شخص من را ترول میکرد و به سیبل پرتاب عقدهها و کمبودهای شخصیتی ادمینها و ناظران تبدیل شده بودم، به من عنوان ترول را دادند.

به قدری روی این عنوان پافشاری کردند که سالها بعد، افراد معلومالحال و پروندهسازی که در اکوسیستم شهره شهر هستند نیز مدام به این موضوع اشاره میکردند و سعی میکردند با این موضوع، دفاعیات شخص من از خود را تا حد زیادی بیمعنا کنند.

این در حالیست که فلسفه نرمافزار آزاد، خلاف این موضوع است. نرمافزار آزاد ذاتا یک مفهوم Intersectional است و به افراد متفاوتی اجازه حضور میدهد، اما با سیستمی که به راه افتاده، هرچیزی را شاهدیم جز این مورد. در واقع به سبک اتحاد جماهیر شوروی، هرکس که در کمیته مرکزی تایید نشود، حق فعالیت ندارد. نمونههای زیادی از این موضوع هم در برخورد با پروژهها و اشخاص دیدهایم.

اینها در حالیست که افرادی با گرایش واضح تجزیهطلبانه، نئونازیستی، چپگرای افراطی و … در گروهها جولان میدهند، دارای تریبون هستند و برای مثال وقتی کسی میگوید «چرا زنی در میان ارائهدهندگان نیست؟» یکهو یادشان میافتد که باید به آزادی برگزارکنندگان احترام گذاشت!

نرمافزار آزاد، در مورد شفافیت است!

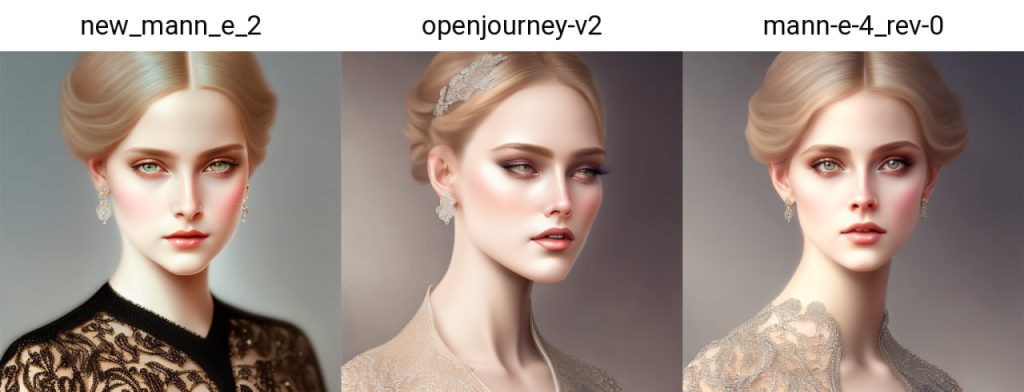

در زمانی که در حوزه نرمافزار آزاد فعالیت میکردم (و بلاشک انتشار چندین کتاب آزاد، انتشار هزاران خط کد آزاد و حتی انتشار مدلهای هوش مصنوعی آزاد که از صفحه گیتهاب من در دسترسند) بلاشک هر «ننه قمری» از راه میرسید یک سوال داشت «پول این کارها را از کجا میآوری؟»

بارها با شفافیت تمام گفتم که هزینه خیلی از این پروژهها، از جیب تامین میشود. برخی را بعضی دوستان حمایت مالی میکنند (برای مثال مدتی شرکت ایرانسرور، اسپانسر پروژههای هوش مصنوعی من بود) و برخی دیگر نیز بخاطر گرنتها (تسهیلات)یی است که خارجیها، برخلاف داخلیها – که فقط ادعای تو خالی و بادمعدهای هستند – دادهاند. جدی بگویم، بسیاری از این خارجیها صرفا تا میشنیدند که قرار است تلاشی مانند مدلهای مانی آزاد باشد، حساب را بدون چون و چرا چند هزار دلار شارژ میکردند و در تبلیغ و بازاریابی نتیجه نیز کمک بسزایی میدادند.

حتی یاد دارم که زمانی که استارتاپ مانی – که شاهدان زیادی مانند دوستان قدیمیام در استارتاپ آرمو داشتم – که با هزینه شخصی ساخته شده بود بسیاری از دوستان میگفتند «از کجا آوردی که چنین چیزی راهاندازی کردهای؟» شاید بهتر بود میگفتم «از سر قبر پدر فلانفلانشدهات» و انقدر خود را آزار نمیدادم.

حالا بیایید فرض کنید که از یک دوستی بپرسید تو که انقدر دست به رویدادت خوب است (با فرض این که تا الان در مورد هزینه و حمایت رویداد شفافیت نداشته) چه پاسخی بدهد خوب است؟ هیچ. در نهایت شما را متهم به ترول و دلقک بودن میکند و خودش میرود به رویدادهایش میرسد. که البته برگزاری رویداد اصلا چیز بدی نیست، من هم ضد آن نیستم فقط میخواستم بگویم که چه در جریان است.

در یک جامعه درست، مخفیکاری جایی ندارد.

تیر ۹۹، با تمام شک و شبهههای دور خودش یک خوبی داشت. مشخص کرد جماعت عریضهنویس همیشه معترض، آن هم از نوع معترض زیرلحافی، شناگران ماهر آبندیده هستند. این شناگران ماهر آبندیده آنجایی خود را نشان دادند که در برابر انجمن نام – که همه چیزش داشت شفاف و درست پیش میرفت – دک و پوز مبارزین عدالت اجتماعی داشتند، اما به خودشان که رسید، تپید!

چرا تپید؟ بسیاری از پروژههایی که واضحا در داخل توسعه مییابند را به نام پروژههای خارجی مطرح کردند. گفتند مشارکتکننده از ایران دارد. در نهایت فهمیدیم که شخصی از ایران، در حال کار روی این پروژه است و اتفاقا شرکت بزرگی از ایران هم پشت آن پروژه ایستاده، فقط برای این که خدای نکرده مورد اصابت ۹۹ تیر سهشعبه قرار نگیرند (چون بهرحال همنوعان خودشان را خوب میشناسند) وانمود کردند که اینطور نیست. وانمود کردند رفت و آمد مالی اینجا اتفاق نمیافتد و صرفا حمایت از نرمافزار آزاد است.

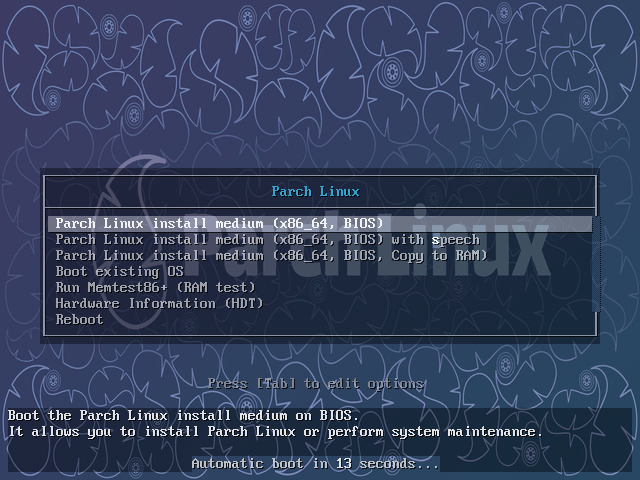

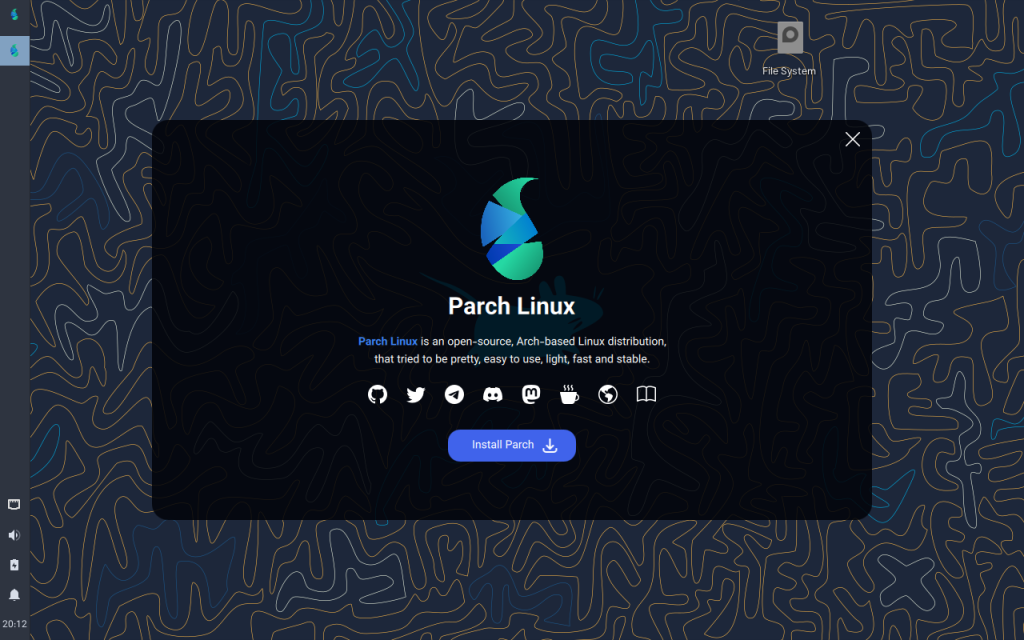

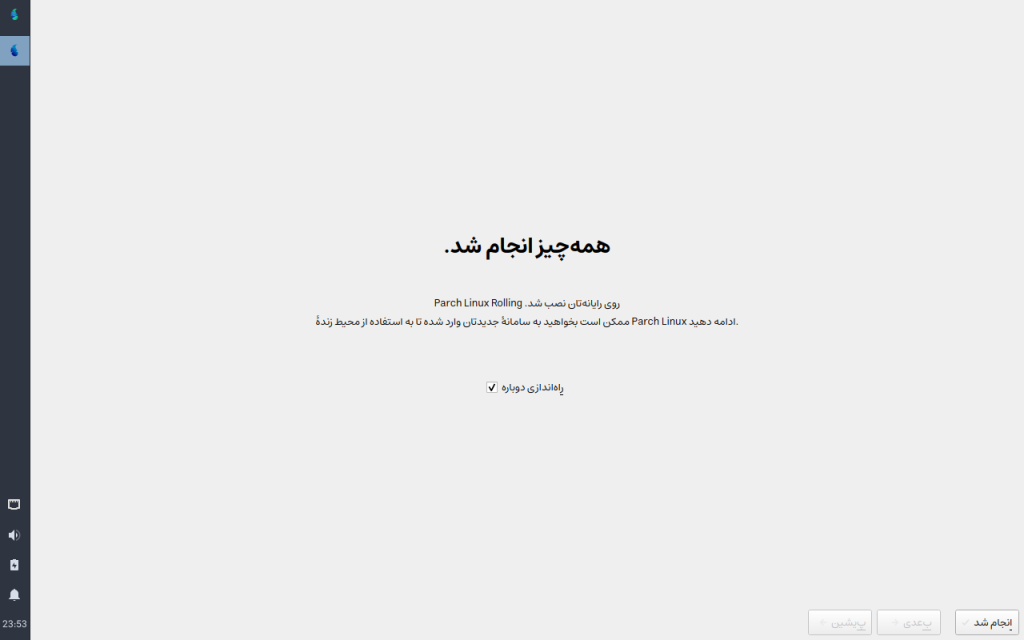

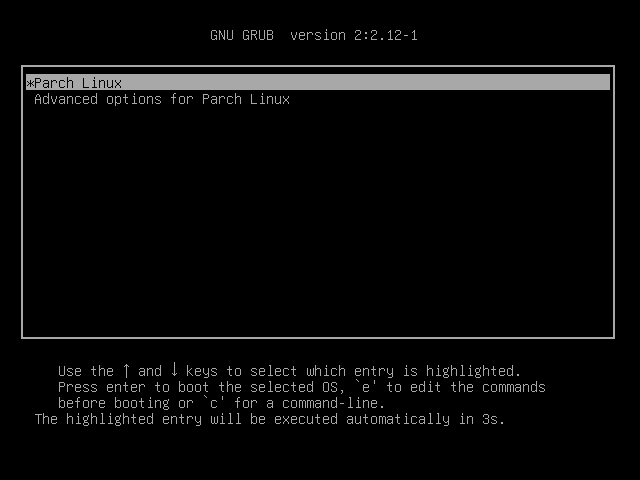

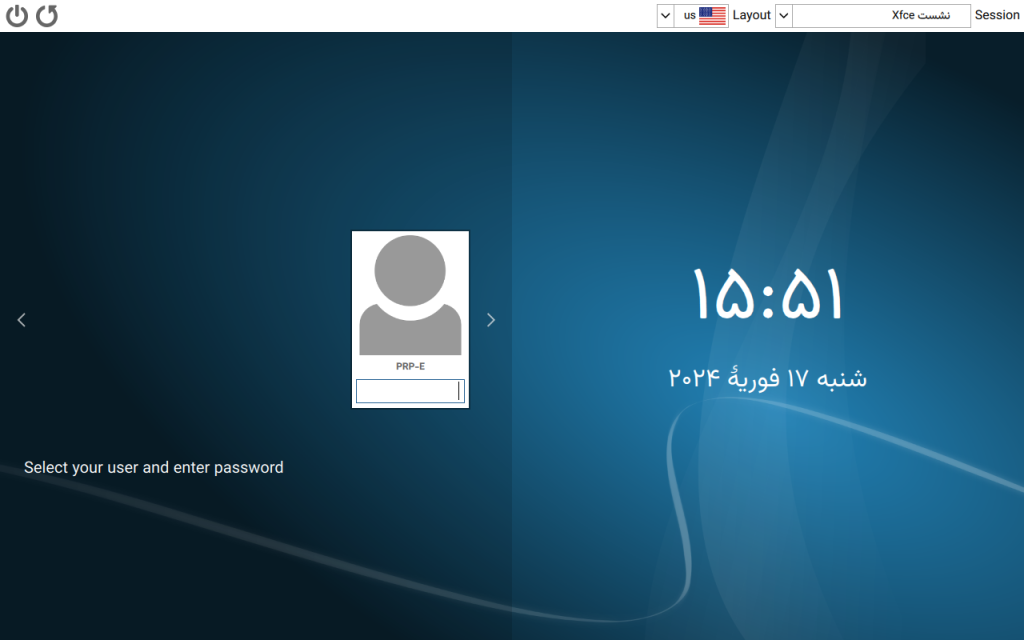

بگذارید دوباره بگویم که حمایت از نرمافزار آزاد بسیار هم خوب است. اما چرا یک بار یکی از این دوستان از پروژههایی مانند پارچلینوکس یا پرسپولیس حمایت نکرد؟ چرا زمانی که مرحوم راستیکردار هنوز در قید حیات بود از ایشان دعوتی به عمل نیامد که سخنران یکی از رویدادها باشد؟ بگذارید باور نکنیم که تنها هدفتان توسعه آزادی نرمافزار است!

از طرف دیگر نیز وقتی دوستان برای اسپانسرهای مورددار – که انصافا انقدر شرف داشتند که نامی از آنها بیاورند – مورد پرسش قرار میگیرند، تنها بازخوردشان مسدود کردن یک کاربر از گروه است؟ علاوه بر آن، از پاسخگویی درست در موردش طفره میروند؟ چرا پیرامون این که کانالهای اجتماعی این رویدادها و اجتماعات بخصوص توسط چه کسی چرخانده میشود صحبت نمیشود؟ یا حتی گفته نمیشود که به نفع چه کسی درآمدزا یا مانتایز شده است؟ پاسخ این سوالات اگر داده شود، بسیاری از این مشکلات حل خواهند شد.

و اما وداع…

گرچه من طبق معمول، به انتشار محتوا، نرمافزار، مدل و … آزاد ادامه خواهم داد و این رویه را متوقف نخواهم کرد. اگر پروژهای ببینم که قابل مشارکت باشد، قطعا در آن مشارکت میکنم.

وداع من با جامعه این است که در هیچ رویدادی مشارکت فعال نخواهم داشت. نه لاگ نه SFD نه رویداد دیگری که اسم «نرمافزار آزاد ایران» را یدک بکشد. همانطور که مانی نیز به زودی با اکوسیستم استارتاپی ایران وداع میکند تا مدتی را صرف تحقیق و تفحص پیرامون بازارهای جدید کنم، ترجیحم این خواهد بود که تمرکزم به جای این رویدادهای بیحاصل – به جز برای برگزارکنندگانی که جیب و رزومه خود را پرمیکنند – بر روی رشد دانش فردی و جمعی باشد.

در نهایت، پیش از آن که این مطلب به پایان برسد، خواهش میکنم این را به خود بگیرید و بدانید که حاضر به شرکت در هیچگونه صحبت دونفره، مصاحبه، مناظره و … پیرامون این مطلب خاص نیستم. چنانچه هم به دنبال مطالعات من در زمینه کارآفرینی هستید، به شما توصیه میکنم که به کانال تینکتانک بپیوندید.

در نهایت از تمامی افرادی که واقعا به مفهوم آزادی احترام گذاشتند، بدون ذرهای چشمداشت مادی رویداد برگزار کردند و مشارکت کردند، نرمافزار و توزیع و سختافزار ساختند، تشکر ویژه میکنم. چنین افرادی در این ناجامعه، بسیار نایابند. امیدوارم در آینده قدردانشان باشیم.

پینوشت: من این مطلب را فقط و فقط در کانال تلگرام ذهن زیبا قرار خواهم داد. انتشار آن در گروهها و کانالهای دیگر توسط دوستان دیگری رخ خواهد داد.